- コンセプト -

人はモノや環境から影響を受けて、自分の行動を決定する。

つまり、人とモノの間には力関係があり、見えない糸で結ばれている。

では、モノとモノはどのような糸で結ばれているのだろうか?

2021

テーマ

モノとモノの関係を可視化する制作期間

2020/04-2021/02

制作体制

個人制作

使用ツール

openFrameworks

TouchDesigner

Teachable Machine

(p5.js / node.js)

人はモノや環境から影響を受けて、自分の行動を決定する。

つまり、人とモノの間には力関係があり、見えない糸で結ばれている。

では、モノとモノはどのような糸で結ばれているのだろうか?

ジェームズ・J・ギブソンのアフォーダンス理論によれば、人はモノの形に影響を受ける。

例えば、椅子は「座る」という行為だけでなく、「背にコートをかける」という行為も誘発する。

また、深澤直人はこのアフォーダンス理論を受けて、「環境と人間」の関係と、「張り」という概念について言及した。

彼は、「環境と人間」を分けるのではなく「人間も環境の一部である」と考え、さらに人間が環境から受ける力を、内側から跳ね返す力のことを「張り」とした。

この2人の考え方を受けて、私は人間が環境から受ける力とは、人間がモノから受ける力だと考えた。では、環境の中にあるモノ同士はどのような関係を持つだろうか?

私は、モノとモノが関係を持つには、間に人間の行為が必要だと考えた。

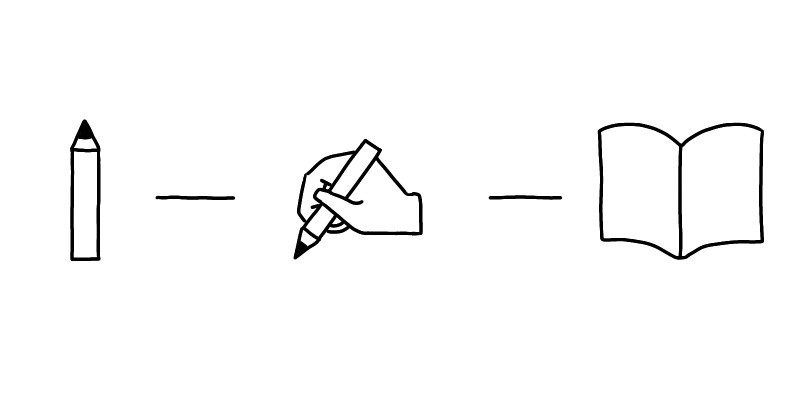

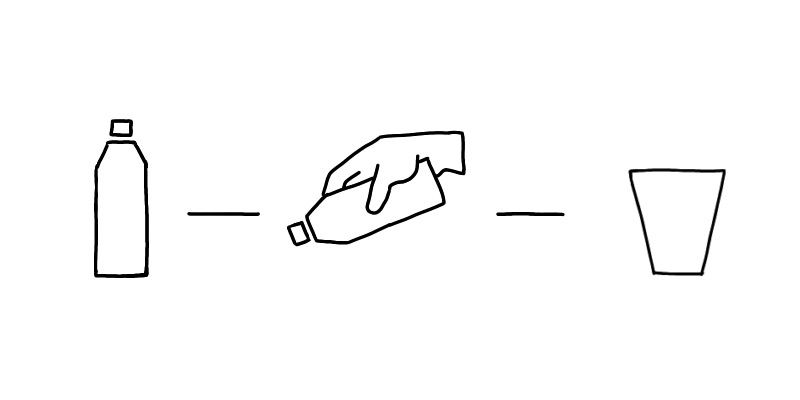

例えば、紙とペンが関係を持つには間に人間の「書く」という行為が必要である。ボトルとコップが関係を持つには、間に人間の「注ぐ」という行為が必要である。

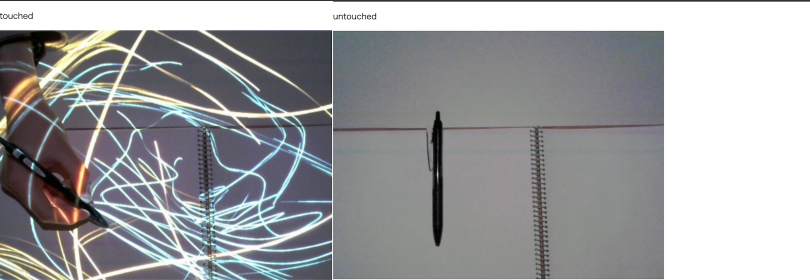

紙とペンは「書く」行為で繋がる

ボトルとコップは「注ぐ」行為で繋がる

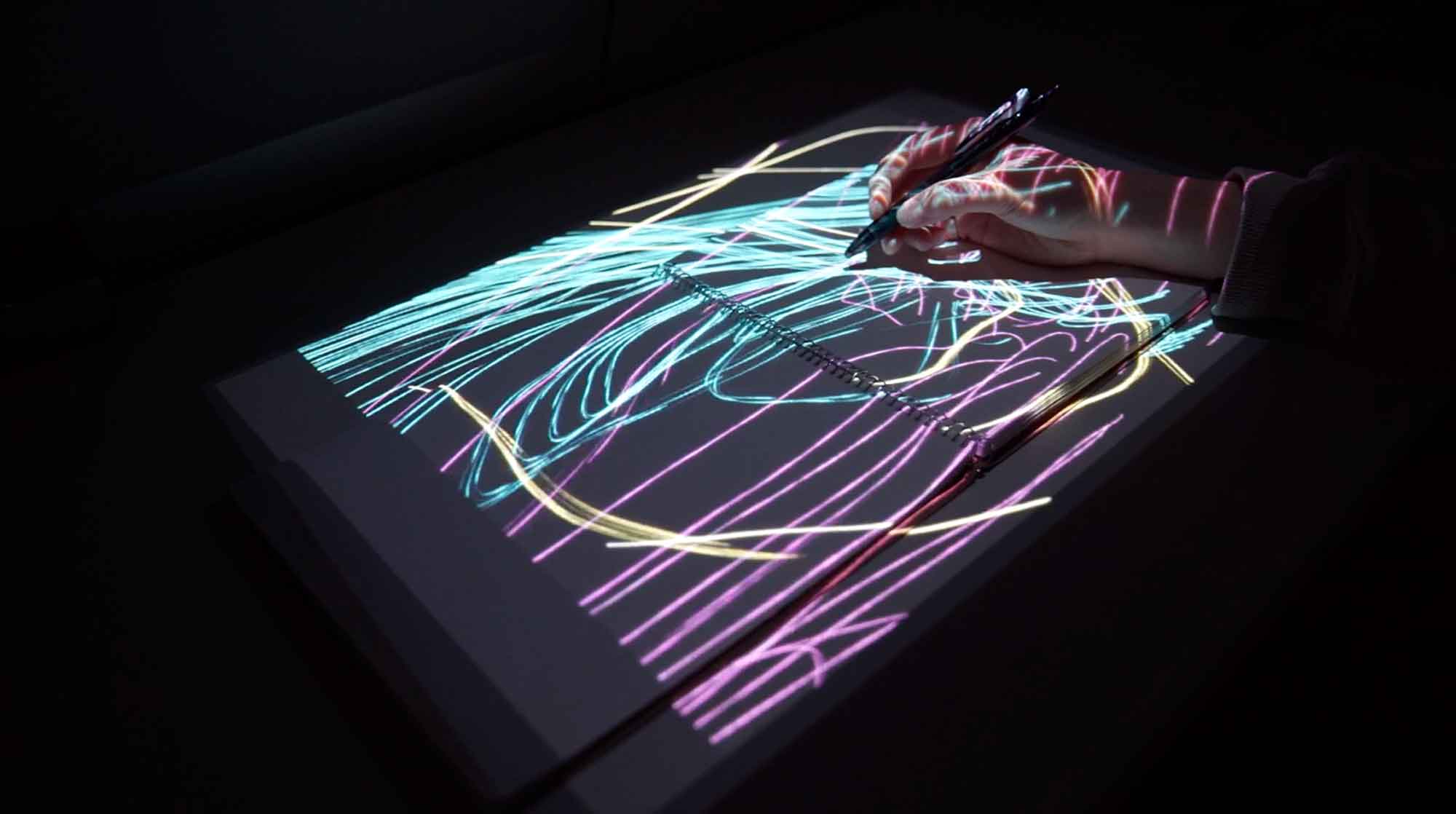

モノとモノが関係をつなぐ行為を人間が行った時に、モノとモノ、そして人間から糸が放出されるようなインスタレーションを制作。

特に今回は、紙とペンと「書く」という行為に着目し作品を制作した。

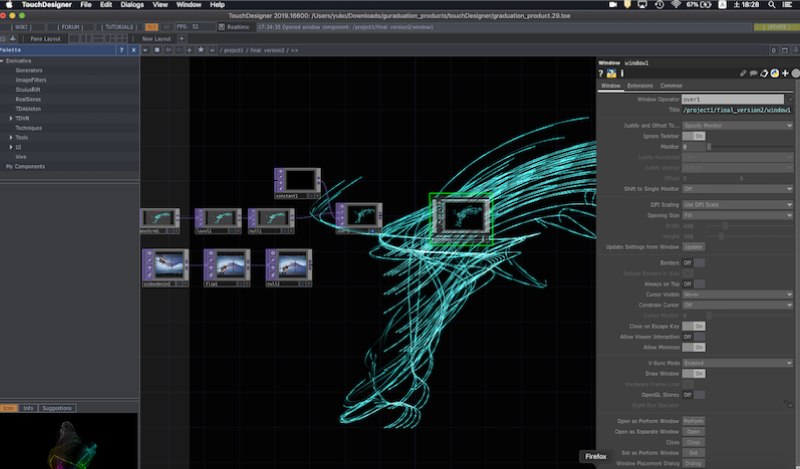

深層学習による物体検知と、画像認識を使った接触判定を行い、その結果をTouchDesignerに送信。

TouchDesignerでビジュアルエフェクトを生成し、それをプロジェクターにより実空間に投影している。

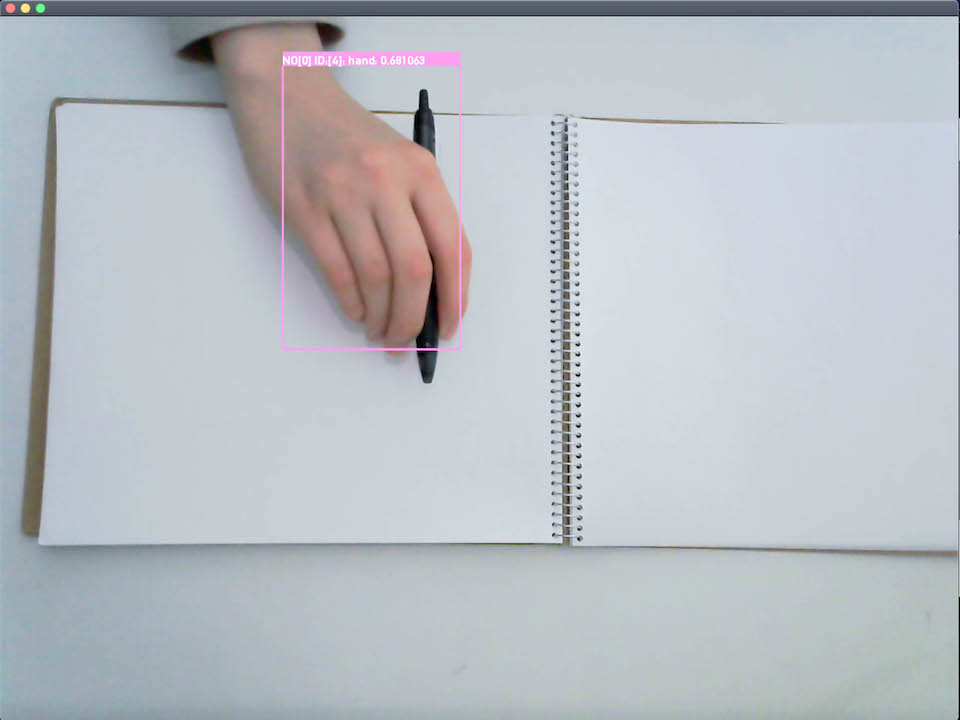

自身で作成したモデルを用いてYOLOによる物体検知を行う。

ペン・人間の手・紙が、カメラ画像のどこにあるのかを検出し、その座標と大きさ、物体の名前をOSC通信で送信している。

Teachable Machineの画像認識システムを使って、ペンが手に触れているか触れていないかを判定。

結果をwebsocket通信でTouchDesignerに送信。

openFrameworks、Teachable Machineから送信された結果をもとに、パーティクルを生成。

プロジェクターで実空間に投影。

この作品の細かな技術については、別途noteを書いているので、よければそちらをご覧ください。

・非接触時の「モノ同士の関係」についてが未実装。

・画像認識や物体検知の精度が甘く、場所や明るさが変わると結果が変わり、汎用性がない。

・Leap Motionでの接触判定を実装。

・学習コスト上、今回学習させたのは紙とペンのみなので、物体検知の範囲を広げる。

・モノによって変化するビジュアルエフェクトの検討を行う。

例)ボトルとコップだと水が流れるようなエフェクト など